Postproduktion und Datenverwaltung von 360-Grad-Aufnahmen. Erfahrungen aus dem Fastnachtsmuseum Narrenschopf

Überblick

Information und Dokumentation

Verwandte Ergebnisse

Da bei 360-Grad-Filmaufnahmen so gut wie keine redaktionelle Feinplanung möglich ist, sondern praktisch nur Kamerastandorte in bestimmten Phasen des Brauchablaufs festgelegt werden können, sind hinterher die Durchsicht des Materials, die Auswahl valider Szenen und deren Anordnung zu einem stringenten Handlungsablauf angesichts der gewonnenen Datenmengen eine Herausforderung, die sich mit der Sichtung und dem Grobschnitt herkömmlichen Filmmaterials nicht vergleichen lässt. Obgleich bei 360-Grad-Technik die Betrachter ihre Blickrichtung selber wählen und damit quasi ihr eigenes Narrativ konstruieren, muss ihnen doch ein chronologisch stimmiger Handlungsablauf geboten werden, der allerdings kein eng geführtes Storytelling üblichen Stils sein kann. Ein Beispiel für solch eine Herausforderung stellte hier die 360-Grad-Präsentation des Grosselfinger Narrengerichts dar, das sich in der Brauchrealität aus mehreren komplexen Simultanhandlungen konfiguriert, weil dort 400 männliche Akteure an verschiedenen Stellen des Dorfes gleichzeitig unterschiedliche, aber doch aufeinander bezogene Spielteile vorführen. Dieses disparate Material hinterher in einen für VR-Rezipienten nachvollziehbaren Ablauf zu bringen und das Gesamtgeschehen als mehr oder weniger lineare Story zu erzählen, erwies sich redaktionell wie schnitttechnisch als extrem anspruchsvoll.

Bibliographische Angaben

- Institution

- Museen der Schwäbisch-alemannischen Fastnacht

- Teilprojekt

- Kulturgut Fastnacht digital

- Autor*innen

- Artur Fuss, Prof. Dr. Werner Mezger

- Veröffentlicht

- 26.09.2022

- Lizenz der Publikation

- CC BY-ND 4.0

- Kontakt

- Ilka Diener

Fastnachtsmuseum Narrenschopf, Bad Dürrheim

info@narrenschopf.de

Entwicklung

Datenverwaltung

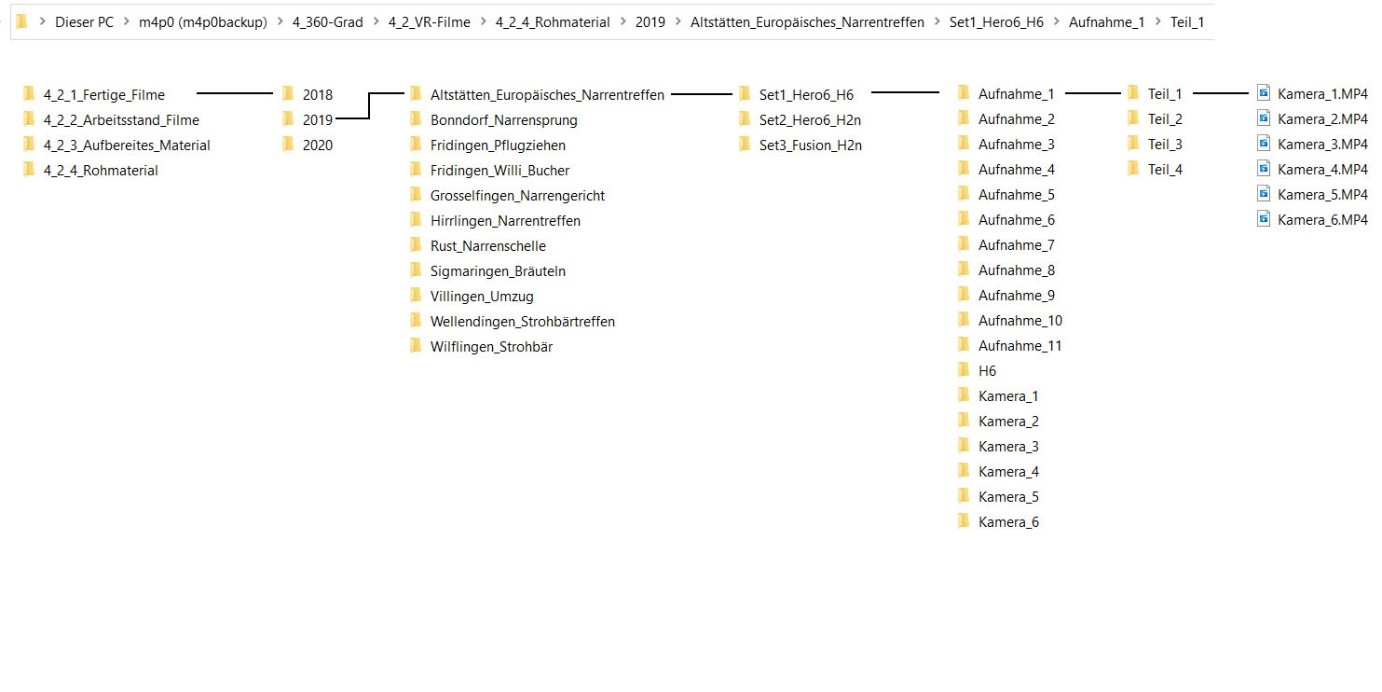

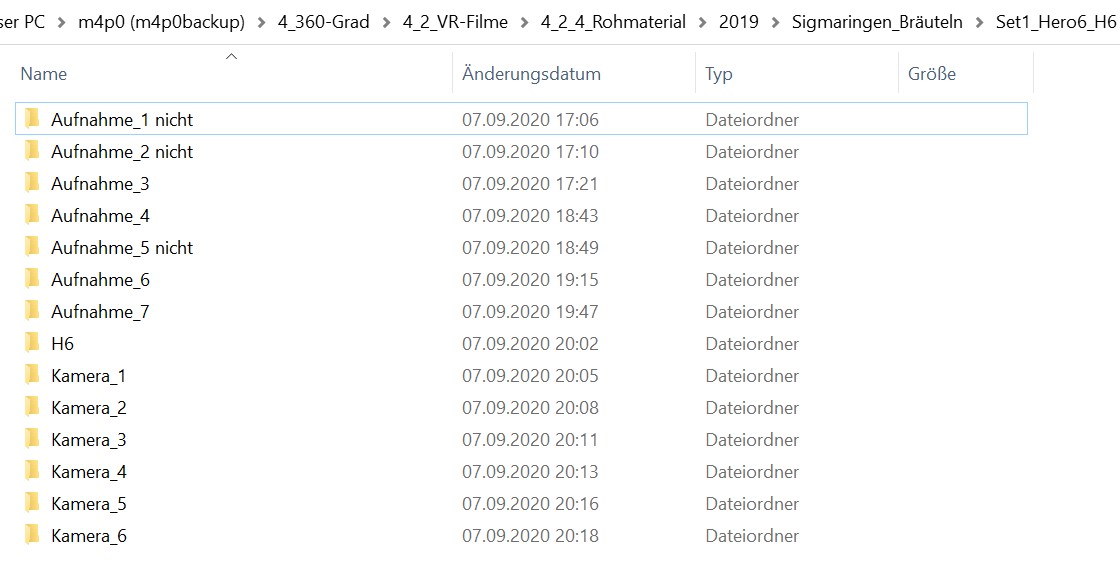

Nach jedem Drehtag werden zunächst alle Daten gesichert und sortiert. Um eine Durchmischung von verschiedenen Bräuchen zu vermeiden, wurden alle Kameras (auch wenn sie am nächsten Tag für einen anderen Brauch eingesetzt wurden) noch am gleichen Tag aufbereitet. Weil mit bis zu 24 Kameras mit je bis zu 128GB Datenkapazität aufgenommen wurde, werden die SD-Karten dieser nach und nach auf einen ausreichend großen Datenträger kopiert. Die Daten jeder Kamera werden direkt in einen namensgleichen Ordner übertragen. SD-Karte von Set_1 Kamera_1 in den Ordner Set_1 Kamera_1 usw. Im Anschluss werden die Daten aus Kamera-Ordnern in Aufnahme-Ordner verschoben. Dabei werden aus jedem Kamera-Ordner entsprechende Videodateien verschoben und benannt, sodass jeder Aufnahme-Ordner die Dateien Kamera_1 … Kamera_6 bzw. Teil_1, … , Teil_X beinhaltet. Selbiges wird ebenfalls für die Audiodateien vorgenommen. Je nach Umfang der aufgenommenen Bräuche entstehen ca. 150 bis 400 Dateien. Die hier aufgewendete Zeit für die Sortierung und Benennung dieser Daten legt die Weichen für eine solide Struktur, die die Nachbearbeitung und Übersicht / Einarbeitung enorm vereinfacht.

Um die Masse an Daten bewältigen zu können – und den zeitlichen Aufwand nicht ausufern zu lassen – werden diese nach technischen und für den Brauch inhaltlich relevanten Kriterien gesichtet und aussortiert.

Technisch:

- Schlechte Sicht durch zu viel Wasser auf den Linsen

- Personen die zu nah an der Kamera stehen

- Aufnahmen mit ungünstiger Position

- Fehlerhaftes Bildmaterial durch Einstellungs- oder Hardwareprobleme

- Einzeln ausgefallene Kameras und somit fehlendes Bildmaterial

- keine Tonaufnahme

- unkorrigierbare Kameraerschütterungen

Inhaltlich:

- Wie gut ist der Brauch zu sehen

- Gibt es Doppelungen im Bildmaterial

- Wie wirkt das Umfeld, ist das Bild gelungen?

- Ist die Szene für die Dramaturgie – den Spannungsaufbau – wichtig/relevant

Diese Vorauswahl findet sich in der Ordnerstruktur wieder und ist die Ausgangslage für die anschließende Postproduktion. Die restlichen Daten werden für dokumentarische Zwecke behalten.

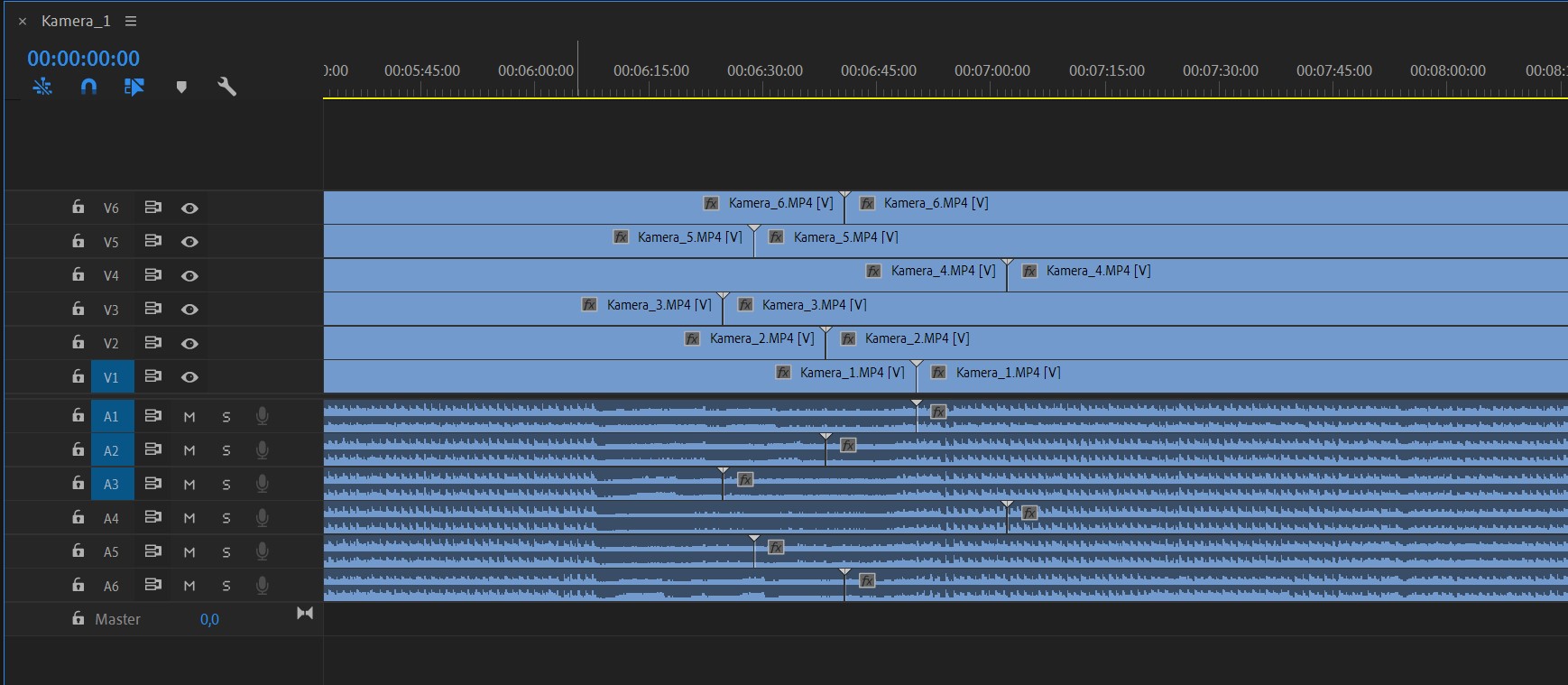

Aneinanderreihung Videos

Hier gilt es die Videos aneinanderschneiden und diese im Anschluss angleichen, synchronisieren, stabilisieren und nähen (im Folgenden stitchen). Es wäre auch die umgekehrte Reihenfolge möglich, allerdings ist es nicht ohne sehr großen Zeitaufwand möglich, die gleiche Szene genau gleich zu stitchen und aussehen zu lassen. Außerdem würde der Aufwand erheblich größer sein, 5x 4-minütige Videos zu stitchen und zu korrigieren als 1x 25-Minütiges Video. Zusätzlich kommt hinzu, dass die GoPro-Kameras während der Aufnahme die Dateigrößen bei 4GB limitieren und anschließend weitere Dateien anlegen. Da die Kameras nicht zum selben Zeitpunkt diese Dateien schneiden und anlegen, entstehen über die Aufnahmedauer von z.B. 30 Minuten ca. 10 Sekunden Unterschied, je nachdem, wann jede einzelne Kamera gestartet wurde. Ein 100% synchrones Starten der Aufnahme war mit unserem Equipment trotz Fernbedienung und paralleler Ansteuerung nicht möglich. Die bereits erwähnten von den Kameras gewählten Zuschnitte können über 10 Sekunden auseinanderliegen, was das Synchronisieren und folglich Stitching von einzelnen Videos erschwert: Es muss länger nach einem synchronen Punkt gesucht werden – wenn überhaupt einer gefunden werden kann – und es wird Material weggeschnitten, um alle Kameras auf den gleichen Punkt zu bringen. Deshalb wird mit den kompletten Längen der Aufnahmen gearbeitet, da ein Kürzen immer leichter ist als ein Verlängern.

Stitching, Helligkeitsanpassung und das erste 360-Grad-Rendering

Die sechs aneinandergeschnittenen Videos (ein Video pro Kamera) werden nun in einer Stitching-Software erneut synchronisiert und miteinander zu einem höherauflösendem 360-Grad-Video „genäht – gestitcht“. Jede der sechs Kameras hat ein anderes Bild und überschneidet sich an den Rändern mit den benachbarten Kameras. In diesem Prozess wird mit den Bildüberlappungen gearbeitet, um ein möglichst homogenes Bild zu erstellen. Werden Mindestabstände nicht eingehalten, ist es nicht möglich diese ohne Schnitte darzustellen, da Bildmaterial aufgrund der Nähe fehlt. Die Überlappungen werden – von Hand – in der Software so gut wie möglich verwendet, um die Übergänge der Kameras zu kaschieren. Da es sich um lebendige Bräuche handelt und somit viel dynamische Bildinhalte zu sehen sind, müssen die Nähte und der Horizont der Sequenzen ständig angepasst werden. Zu viel Bearbeitung kann allerdings auch auffällig werden, weshalb ein dezenter Eingriff in das Material meist ausreichend ist.

Die Helligkeitsunterschiede weichen zwischen den Kameras ebenfalls ab. Die Hälfte der Kameras ist immer in Richtung Boden geneigt während die andere in Richtung Himmel schaut. An sonnigen Tagen oder punktuellen Beleuchtungen müssen deshalb die Helligkeitswerte und Farbwerte (normalerweise sind die Bilder nativ und eine Farbangleichung der einzelnen Kamera nicht nötig) der einzelnen Kameras aneinander angeglichen werden.

Sichtung und Grobschnitt

Wenn das Material für den Schnitt vorbereitet ist, wird es anschließend – meistens im chronologischen Brauchablauf – grob und nach inhaltlicher Relevanz geschnitten, was eine erneute Sichtung der Videos und Aussortieren nach den für den Brauch bedeutende, interessante, erlebnisreiche sowie für Rezipient*innen spannende Bildern bedeutet. In den Aufnahmen ist zu sehen, dass die Stative nicht rausretuschiert werden. Das Ergebnis würde den zusätzlichen Aufwand nicht rechtfertigen, zumal das Stativ ohnehin nicht präsent im Bild ist. Außerdem zeigte sich, dass Nutzer*innen beim Betrachten des 360-Grad-Erlebnis in VR-Brillen durch den fehlenden Anhaltspunkt am Boden schneller Schwindel und Unwohlsein erleiden. Oft wurde berichtet, dass das Gefühl von „schweben“ eintritt. Für die Aufbereitung des Materials für die Kuppelprojektionen wird der Großteil des unteren Bildinhaltes abgeschnitten, was das Stativ obsolet macht.

In manchen Aufnahmen zeigte sich erst in diesem Verarbeitungsschritt, dass manches Videomaterial beschädigt war. Dies zeigte sich durch ein grünes oder rotes Bild anstatt des eigentlichen Materials. Dieses Material konnte nur schwer „gerettet“ werden, indem es mit der Xbox-Game-Software aufgenommen und erneut in Adobe Premiere zusammengerechnet wurde. Die native Auflösung und Framerate konnte dadurch nicht immer sichergestellt werden; allerdings fällt solches Material nicht groß auf, da eine einzelne Kamera bei einer reduzierten Auflösung von 1500×1500 Pixel immer noch ausreichend ist, um ein Teil eines 4k-Videos zu sein.

Da die VR-Brillen bzw. -Filme in der Dauerausstellung genutzt werden, werden die Filmlängen so kurz wie möglich und so lang wie nötig gehalten. Ziel ist es, dass Museumsbesucher*innen noch ausreichend Zeit für die restliche Ausstellung haben und die Akkus der Brillen von einem Rezipienten nicht bereits entladen werden und der nächste Interessent warten muss. Für Brillenfilme sind Videos mit Längen von 4-9 Minuten geeignet. Für Kuppelprojektionen zeigt die Erfahrung, dass eine Vorstellung / Vorführung von ca. 20 Minuten eine geeignete Länge ist.

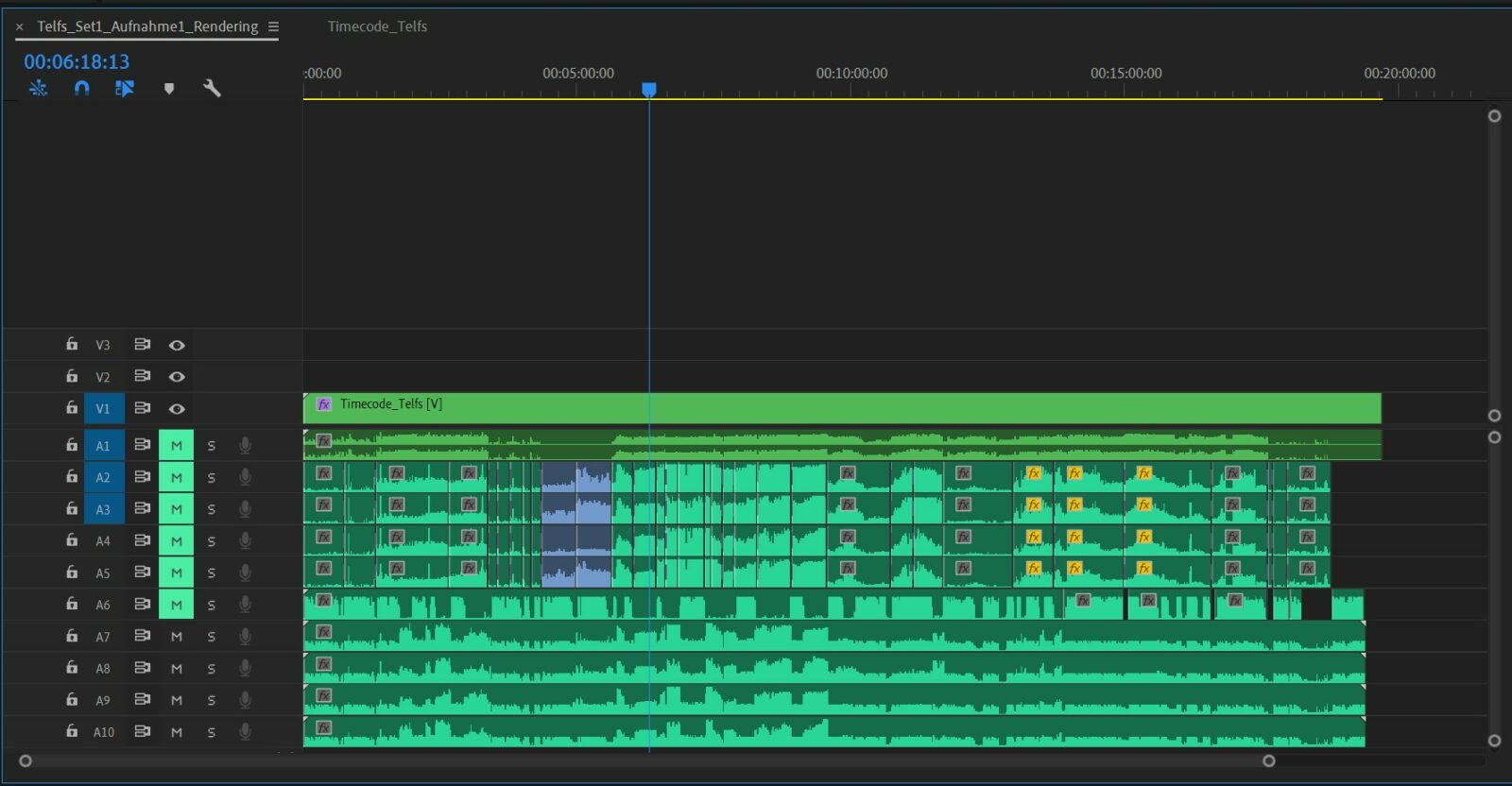

Tonstudio

Wenn die Anordnung der Sequenzen abgestimmt ist, wird ein Timecode über das Video gelegt und gerendert. Für das Tonstudio wird ein .mov Format verwendet und der Sprechertext auf den Timecode abgestimmt. Während der Tonaufnahme in einem professionellen Tonstudio wird das Video für den Sprecher bereitgestellt und eingesprochen. Im Anschluss werden die Audioaufnahmen normalisiert und ein „De-Esser“ zum Entfernen von Zischlauten verwendet. Die fertige Audiodatei wird als .wav-Format ausgegeben und nun – mit möglicherweise neuem Zuschnitt – auf das Video gelegt. Der Originalton der Kameras wird zu Beginn als Synchronisationspunkt genommen, um den Ton der Mikrofonaufnahmen zu synchronisieren und zu schneiden.

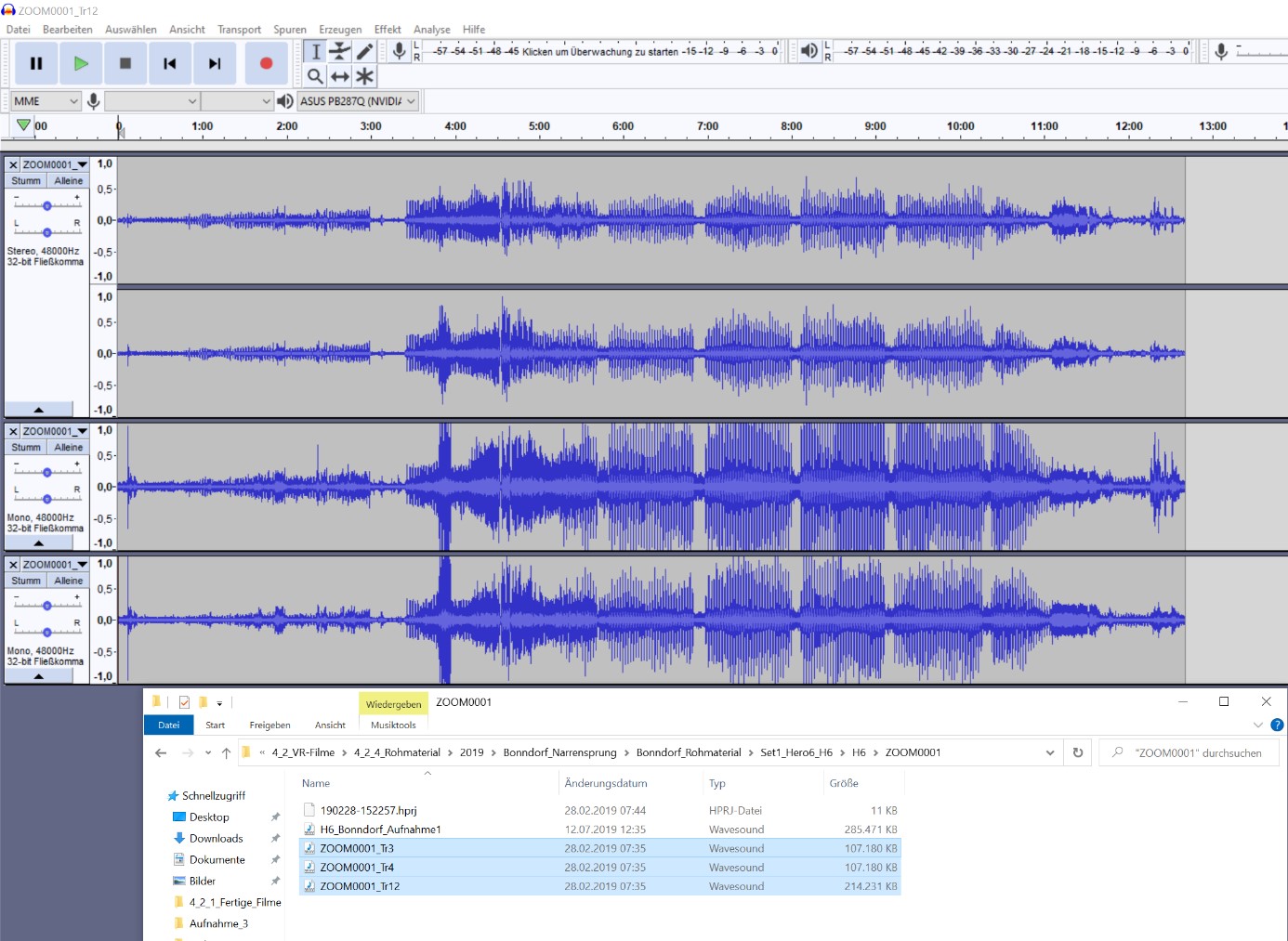

Audiobearbeitung

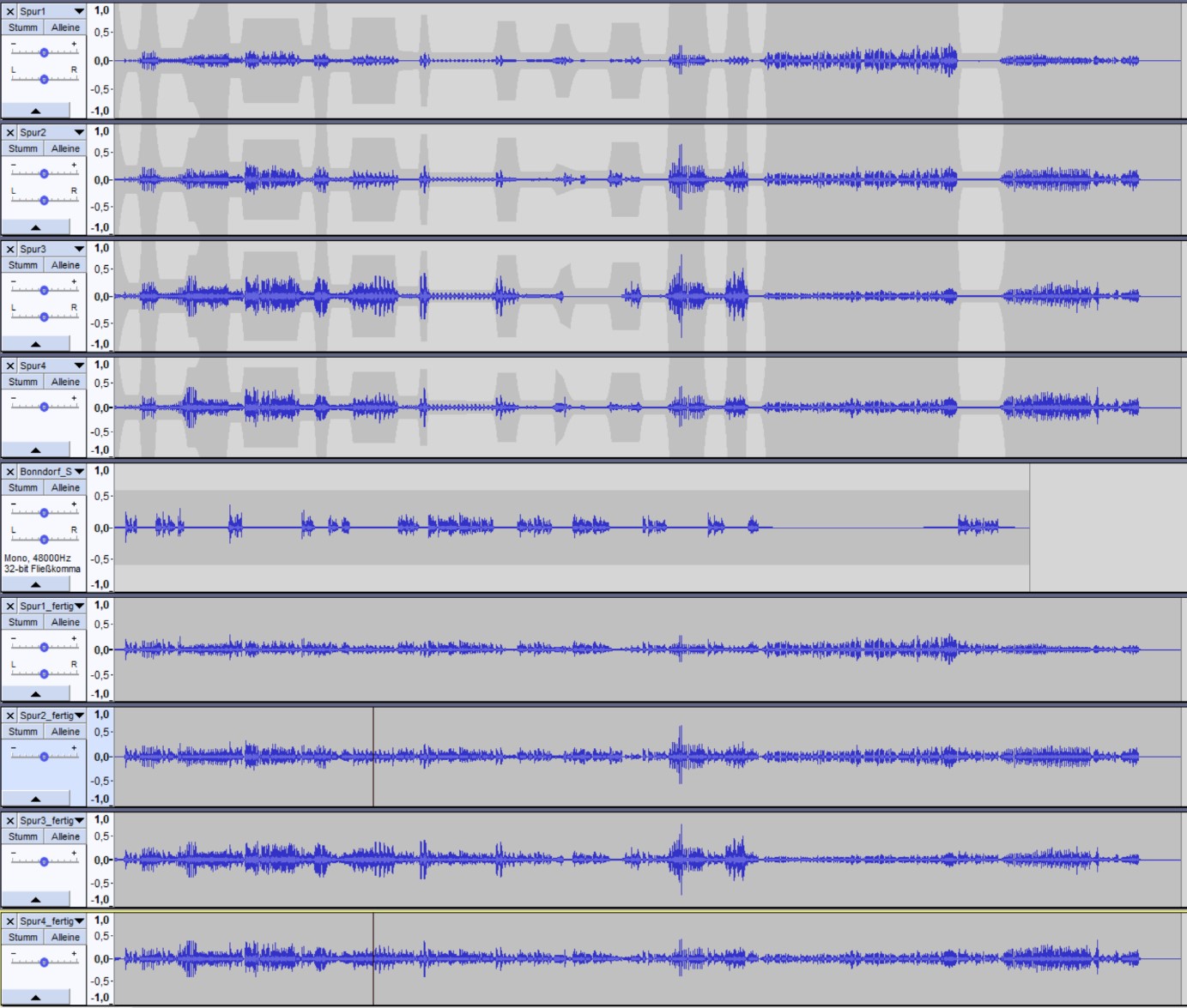

Um die Videos möglichst immersiv zu machen, müssen die originalen Audiodateien der Mikrofone zunächst aufbereitet werden. Bei Kopfbewegungen soll nicht nur das Bild, sondern auch der Ton bewegt werden. Hier wird zwischen den unterschiedlichen Aufnahmegeräten – H2n und Sennheiser Ambeo sowie H6 Recorder – unterschieden. Bei einem H2n werden die Kanäle links/rechts und vorne/hinten aufgenommen, bei einem H6 zusätzlich oben/unten – aufgenommen, bei einem H6 vier – links/rechts, vorne/hinten, oben/unten. Bei Audioaufnahmen von H2n-Mikrofonen kann die fehlende Audiospur für oben/unten aus einer anderen kopiert werden oder leer gelassen werden. Bei Audioaufnahmen mit dem anderen Set müssen zunächst zwei zweispurige Audiodateien zu einer vierspurigen Audiodatei exportiert werden. Diese vierspurige Datei wird in Reaper umgewandelt, um das Aufnahmeformat in einen Raumklang umzuwandeln. Mit zusätzlichen Plugins ist es ebenfalls möglich, die Richtung des Audios zu verändern. Die einzelnen Audiodateien werden aneinander angeglichen, sodass sie gleich laut sind. Des Weiteren werden Audioüberblendungen eingefügt, damit der Ton nicht schlagartig abbricht.

Im Anschluss werden die Audioaufnahmen des Tonstudios mit den Mikrofonaufnahmen gemischt. Der Sprechertext wird einspurig aufgenommen und ist somit nur auf einem Kanal angelegt. Da die Mikrofonaufnahmen aber vierspurig sind, muss nun der Sprechertext mit jedem dieser Kanäle gemischt werden, damit dieser nicht nur auf einem Ohr zu hören ist: Ziel ist es, den Sprecher überall gleich klingen zu lassen.

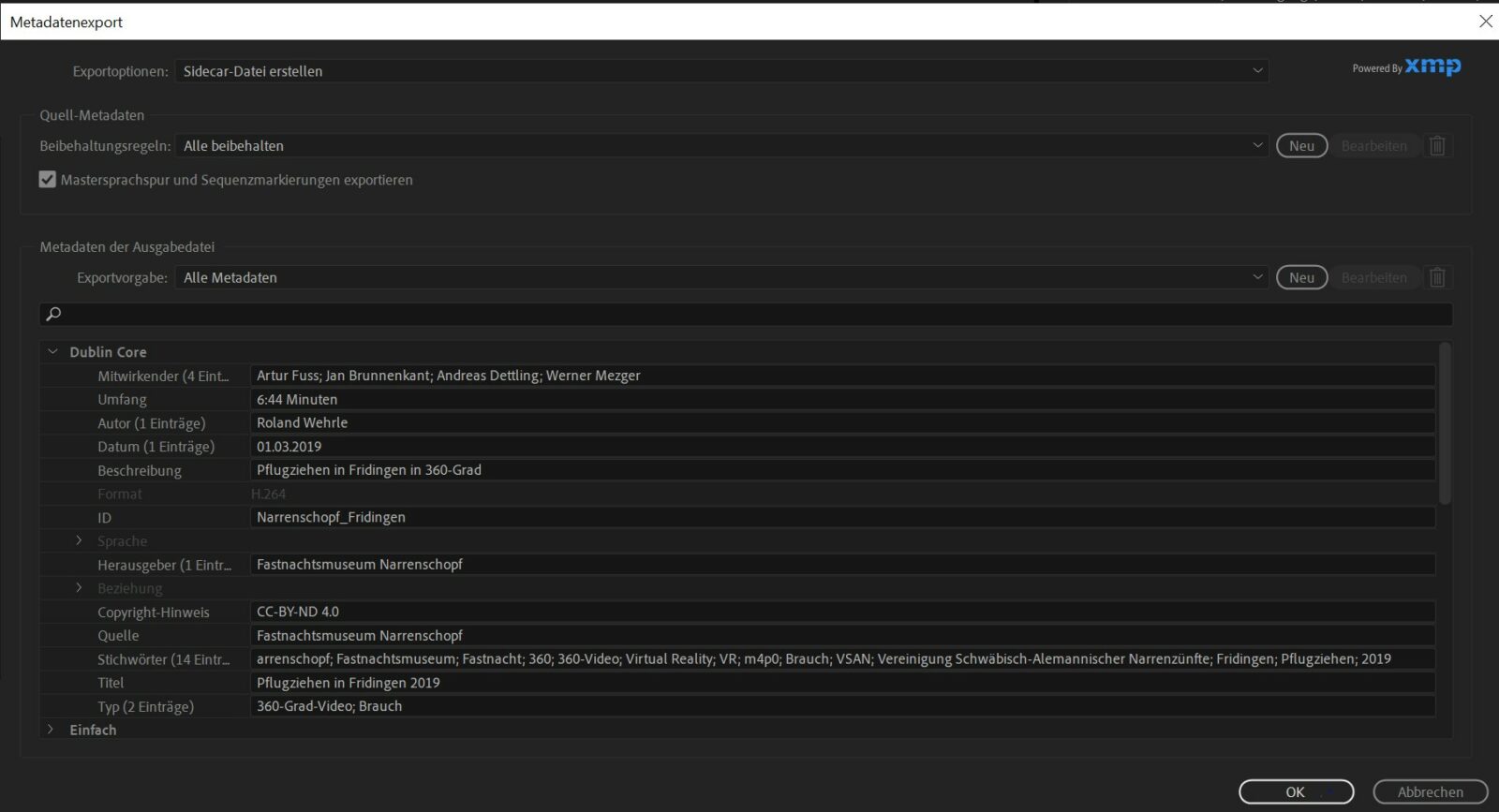

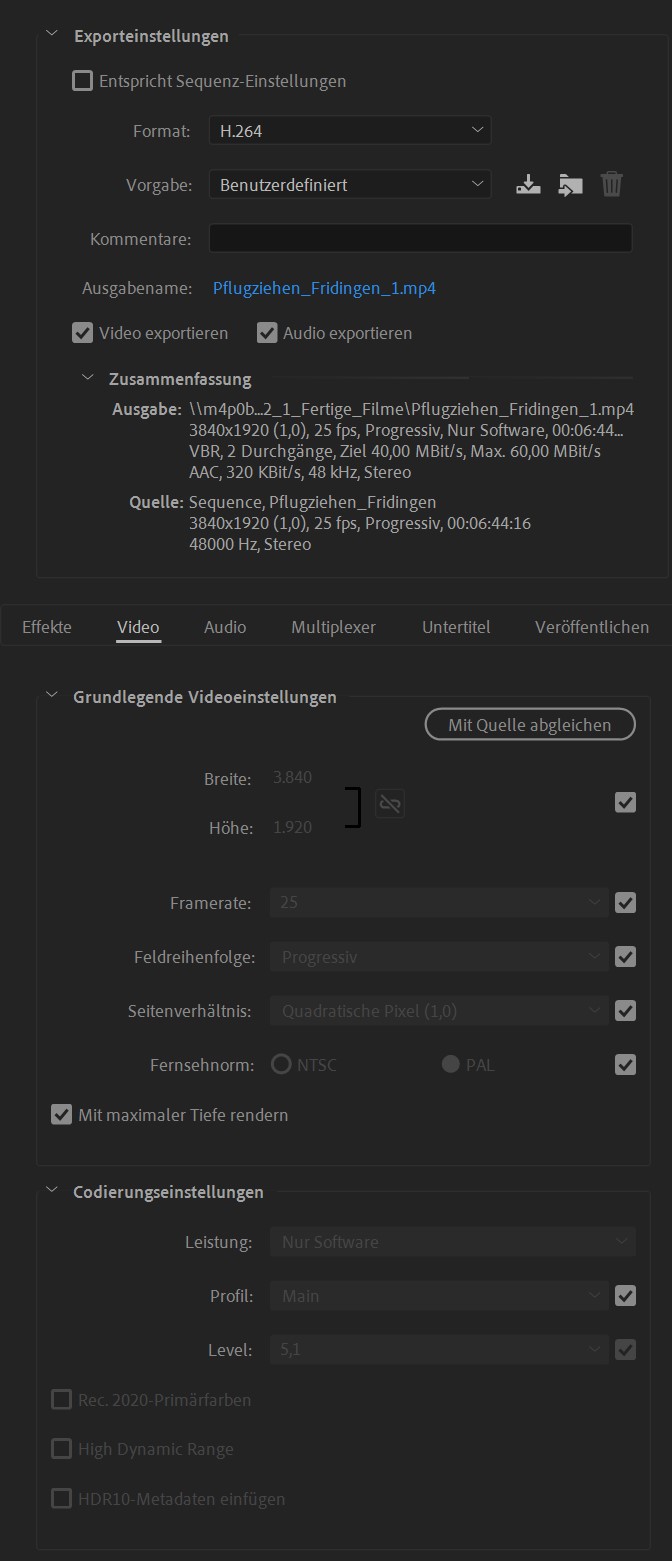

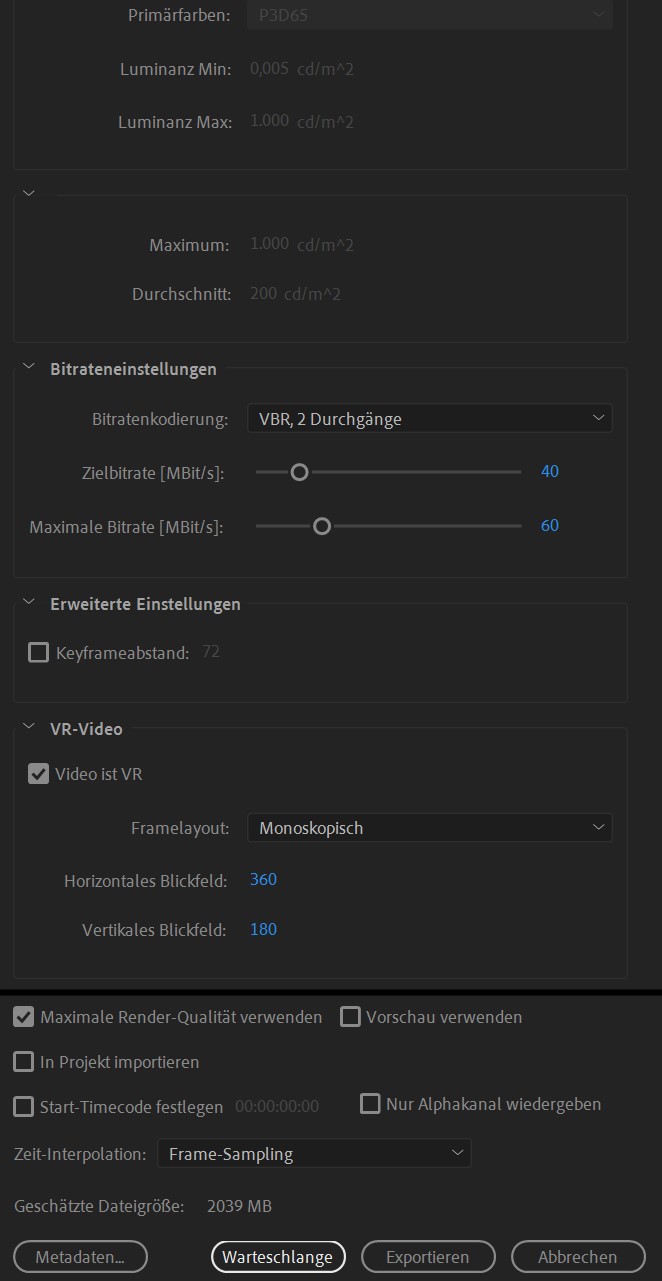

Finale Bildbearbeitung und Rendering

Wenn der Ton komplett fertiggestellt ist, werden zwischen allen Sequenzen weiche Blenden eingebaut und das Material farbkorrigiert. Zuletzt werden – je nach Film – noch Vor- und Abspann eingebaut und der Film je nach Zielformat direkt mit oder ohne Ton exportiert. Das aktuell gängige Format hierfür ist .mp4. Für einen immersiven Ton wird das .mov Format gebraucht, da in einem weiteren Schritt das Video mit dem Audio unterlegt wird. Für das Web und die im Museum verwendeten VR-Brillen wird das Video allerdings direkt mit Audio aus Adobe Premiere exportiert.

Beim Datenexport zeigten sich Schwächen bei der Adobe-Suite: Es war aufgrund von unbekannten Fehlern nicht immer möglich, VR-Effekte auf das Material anzuwenden, ohne eine Fehlermeldung in Form einer Binde mitten auf dem Material zu haben. Eine Lösung dafür war, die einzelnen Videos nicht über den Adobe Media Encoder, sondern direkt aus Adobe Premiere zu exportieren. Der Export hierfür erfolgte als Video in 3840×1920 mit quadratischen Pixeln mit 25 Bildern/Sekunde.

Dramaturgie

Lange Abläufe wie z.B. das rituelle Aufstellen eines Baumes werden reduziert, das Klettern auf diesen Baum aber in voller Länge gezeigt. Um die Rezipient*innen nicht zu langweilen, werden sich wiederholende Bilder nach 1-2 Iterationen nicht mehr gezeigt, da sich die Besucher*innen davon „sattgesehen“ haben.

Musik dient als Träger von Videos während nicht so „spannenden“ Aufnahmen. Ebenfalls werden schlecht verständlichen Ansager und Vorredner gedämpft, um sie anschließend mit eigenen Sprechertexten übertönen. Da wir 360-Grad-Videos haben, ist es den Zuschauer*innen möglich, jederzeit in eine andere Richtung zu schauen. Wir geben indirekt eine Richtung vor, indem wir auf der Ausgangsposition das Hauptgeschehen darstellen. In den meisten Aufnahmen ist im restlichen Bild nicht viel zu sehen (Hauswände, Zuschauer, Darsteller von hinten). Rotationen von Bildmaterial verwirrt die Zuschauer und können schnell Schwindel hervorrufen. Das Videomaterial muss zudem für Rezipient*innen in VR-Brillenstabilisiert werden. Farben und Konturen müssen noch stärker als gewöhnlich hervorgehoben werden, da die Qualität der Wiedergabegeräte oft nicht die Beste ist.

Bei 360-Grad-Produktionen können und müssen einzelne Kamerapositionen wesentlich länger beibehalten werden als im analogen Film, weil Zuschauer*innen sich in der virtuellen Wirklichkeit in jeder gewünschten Richtung selbst umsehen können, wofür genügend Zeit sein muss. Relativ statische Vorgänge, wie etwa die Arbeitsschritte beim Aufstellen eines Narrenbaums, die wenig abwechslungsreiche Aktionen zeigen, müssen ggf. erheblich gekürzt werden. Kürzungen wie auch Standortwechsel des Kamerastativs sind in der Wiedergabe am besten über weiche Schnitte zu lösen. Harte Bildschnitte verwirren die Betrachter*innen und stören die Illusion des Dabeiseins empfindlich. Die durch Bildblenden bedingten Tonwechsel in der Geräuschkulisse können entweder durch sanfte Tonblenden der Atmo reduziert oder durch den Offtext „übersprochen“ werden, so dass sie für den Rezipienten in der Vielfalt der Eindrücke untergehen. Spezielle Anforderungen stellt das Anlegen der Offtexte, die zur Erklärung des Geschehens nötig sind. Sie müssen sorgfältig bedacht sein und präzise auf den Timecode gesprochen werden, wobei im Vergleich zum Texten herkömmlicher Filme oder Kommentieren von Fernsehliveübertragungen nicht einfach nur nach bekanntem Muster „auf Bild“ getextet bzw. gesprochen werden kann. Weil die Betrachter*innen ihre individuellen Blickwinkel und Bildausschnitte selbst wählen, sich vielleicht sogar vom Hauptgeschehen abwenden und Marginales betrachten, weil jeder etwas anderes sehen kann, müssen die Textinformationen tendenziell allgemeiner gehalten sein, ohne am Wesentlichen vorbeizugehen oder von vornherein Text-Bild-Scheren in Kauf zu nehmen: in gewisser Weise eine Quadratur des Kreises. Wenn nötig, muss explizit gesagt werden, wo gerade was geschieht. Als geschickter Trick zur „proaktiven“ Lenkung des Blicks erweist sich aber auch, auf etwas Wichtiges, was gleich geschehen wird, bereits vorher aufmerksam zu machen. Das sensibilisiert die Betrachter*innen, sich selber umzusehen, weil das Angekündigte nicht versäumt werden will. Im Vergleich zum Texten herkömmlicher Filme oder zur Kommentierung von Livesendungen stellt das Synchronisieren von 360-Grad-Filmen zweifellos deutlich höhere Anforderungen.

Datensicherung

Hardware

Externe Festplatten kamen zu Beginn des Projektes als Zwischenspeicher zum Einsatz, am Ende der Projektlaufzeit wurden diese zur zusätzlichen Sicherung der Daten verwendet. Hierfür wurden 2TB Festplatten von WD-Digitals verwendet.

NAS-Server

Gesucht wurde ein Netzwerkspeicher (Network Attached Storage), der ausfallsicher ist und ausreichend Erweiterungsmöglichkeiten bietet. Das Fastnachtsmuseum Narrenschopf hatte bereits ein NAS-System von Synology, welches sich durch seine an Windows angelehnte Darstellung und Handhabung auch für unerfahrene Nutzer*innen als benutzerfreundlich erwiesen hatte. Um die Einarbeitungszeit gering zu halten und die Nachhaltigkeit zu gewährleisten, fiel die Wahl auf ein vergleichbares System für den NAS-Server. Erfreulicherweise ist durch seine interne Systemkompatibilität eine nachträgliche Erweiterung um weitere Geräte möglich.

Die Festplattenkapazität wurde anhand der Erfahrungen festgelegt: Pro Fastnachtsveranstaltung fielen ca. 500GB bis zu 1,5TB Daten an. Bei 20 geplanten Bräuchen würden somit bis zu 30TB Daten anfallen. Um eine Ausfallsicherung zu gewährleisten und eine interne Datenspiegelung zu ermöglichen, wurde das System als RAID 10 aufgesetzt. Für die Datenspiegelung wird das doppelte Volumen benötigt, weshalb es ein ausreichend großes System benötigt wird. Die Wahl fiel auf ein 8-Bay (8 Einschübe/Festplatten) mit 8x8TB = 64 TB. Bei den Festplatten wurden Ironwolf Seagate gewählt, da diese für den NAS-Betrieb optimiert und langlebig sind.

Um die Übertragungsgeschwindigkeit der Technik optimal zu nutzen – und für die nächsten Jahre auf dem Stand zu halten – wurde ein Cat.7 Lan-Kabel verlegt. Die Übertragungsrate eignet sich für 10-Gigabit-Netzwerke (10.000Mbit/s) und garantiert, das NAS-seitig die Übertragungsgeschwindigkeit ausgeschöpft wird.

Software

Aufgrund der Kooperation zwischen GoPro und Kolor fiel die Wahl auf die Autopano-Suite – Autopano Video Pro, Autopano Giga, Panotour. Durch diese ist ein Stitching des Materials und Erstellung von 360-Grad-Touren enorm einfach.

Zur Bild- und Videobearbeitung wurde die Adobe-Suite genutzt.

Zur Audiobearbeitung wurde Audacity verwendet. Zur Umwandlung von rohen 360-Spatial-Audiodateien und Ausrichtung dieser wurde Reaper verwendet.